Топ-8 худших процессоров за всю историю компьютеров

За всю полувековую историю компьютеров различные компании выпустили несколько сотен процессоров. Разумеется, среди них были отличные для своего времени решения, были просто хорошие, и конечно же были CPU, при изучении которых возникал вопрос — зачем ЭТО вообще было выпускать? И именно о таких процессорах мы сегодня и поговорим.

Intel Itanium (2001)

Эти процессоры были попыткой получить очень высокий уровень производительности в параллельных вычислениях без увеличения частот. Так, они могли выполнять до 6 инструкций за такт (к примеру, современные Core i умеют всего 4), обладали кэшем в 24 МБ (против сотен килобайт у Pentium тех лет), 64-битную адресацию памяти (и это за 5 лет до выхода пользовательских 64-битных систем) и очень эффективное ядро, которое существенно повышало производительность CPU при работе с несколькими потоками задач.

Увы — как говорится, такие решения «не взлетели». Да, с одной стороны, в режиме IA-64 это был самый быстрый процессор для вычислений с плавающей запятой, но вот в целочисленных вычислениях он был на уровне обычных x86-процессоров с той же частотой. Более того — если x86-код не был оптимизирован под Itanium, то производительность могла упасть до 8 раз в сравнении с x86-CPU с такой же частотой! Также стоит отметить, что кэш третьего уровня (L3) имел хоть и огромный по тем временам объем, но все же по скорости он был несильно быстрее ОЗУ, что опять же тормозило процессор.

Ну и окончательно «добило» Itanic (шутливое название Itanium, созвучное с Титаником) то, что его выпустили спустя 3-4 года после задуманного срока (ибо Intel приходилось конкурировать с AMD с сегменте пользовательских CPU, и Itanium постоянно откладывали). В итоге выход в продажу совпал с коллапсом рынка доткомов, что повлекло за собой падение продаж серверов, а с учетом того, что на рынке тогда были такие мастодонты, как IBM с архитектурой POWER и Sun со SPARC — затея Intel провалилась.

Конечно, компания всеми силами пыталась спасти свое детище, и в итоге последние процессоры этой линейки вышли аж в 2017 году (правда, на 32 нм техпроцессе 5-летней давности), но, как мы знаем, заменить x86 они так и не смогли, и сейчас в высокопроизводительном сегменте царствуют Xeon.

Intel Pentium 4 Willamette на Socket 423 (2000)

Слева — «нормальный» P4 для Socket 478, справа — «плохой» P4 для Socket 423.

В 2000 году Intel запускает линейку процессоров Pentium 4, а вместе с ней и новый сокет 423. И все бы хорошо, но вот только из-за конструкционных особенностей производство CPU с частотой выше 2 ГГц для такого сокета было просто невозможным, и в итоге в 2001 году компания переходит на достаточно известный и даже до сих пор используемый в ультра-бюджетных б/у ПК Socket 478, под который уже выходили Pentium 4 с частотой вплоть до 3.4 ГГц.

Конечно, пользователи были очень «рады» тому, что их новенький сокет устарел спустя полгода, и в итоге был даже сделан адаптер, позволяющий устанавливать процессоры для Socket 478 на 423, но вот сами Pentium 4 для этого сокета можно смело назвать неудачным вложением средств.

Cyrix 6×86 (1996)

Сейчас выпустить x86-совместимый процессор практически нереально — все патенты на них поделены между Intel, AMD и VIA. Но вот в 90-ые с этим было все проще, и на рынке существовала линейка процессоров Cyrix, которые можно было использовать в тех же сокетах, что и Intel Pentium, но при этом стоили такие решения все же дешевле.

Более того, «курики» в целочисленных вычислениях были существенно быстрее Pentium тех лет — к примеру, 133 МГц Cyrix мог на равных работать с 166 МГц Pentium, и тогда это имело смысл, ибо большая часть офисного софта использовала как раз целочисленные вычисления. Проектировщики Cyrix думали, что так будет и дальше, и прогадали — мир стал переходить на вычисления с плавающей точкой.

И тут низкая производительность FPU (математического сопроцессора) у 6×86 дала о себе знать — во-первых, инструкции выполнялись минимум за 4 такта, во-вторых, они не были конвейеризированы. В итоге с плавающей точкой Cyrix работали на уровне Intel 486, а с учетом популярности Pentium программисты напрямую стали работать с ассемблером для извлечения максимальной выгоды от конвейеризированного и работающего с малыми задержками FPU Pentium. В результате в том же Quake разница в производительности между Pentium и Cyrix была почти двукратная, и с учетом того, что такого софта с каждым годом стало становиться все больше — преимущество Cyrix достаточно быстро сошло на нет.

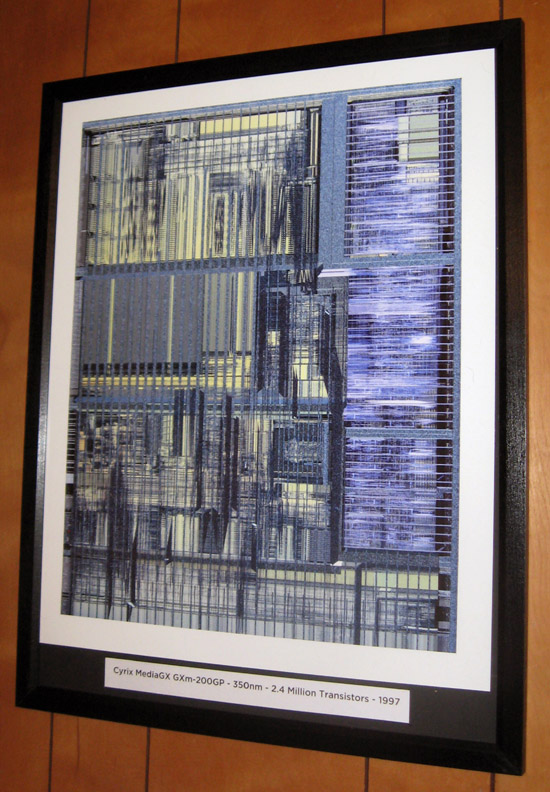

Cyrix MediaGX (1997)

Понимая, что «пора хватать чемоданы, вокзал отходит», компания стала метаться в попытках изобрести что-то новое, и итогом стала SoC MediaGX. Да-да, именно система-на-чипе — внутри было процессорное ядро 5×86, модули для работы с видео и аудио, контроллеры PCI и ОЗУ.

Идея была, конечно, хорошая, но вот компоненты были подобраны ужасно: так, 5×86 был конкурентом по целочисленным вычислениям лишь для Intel 486 (и это уже во времена Pentium II), не умел работать с кэшем L2 и имел совместимость с очень немногими платами, которые были рассчитаны именно под этот CPU.

В итоге эта SoC нашла применение лишь в нескольких компактных ноутбуках, где развернуть систему с полноценным CPU и графикой не представлялось возможным (а тут еще и видеопамять как таковая была не нужна — использовалась ОЗУ). Так что идея сделать SoC была отличная, и, как мы знаем, сейчас ее активно используют, но вот реализация была ужасной, что и погубило эту линейку чипов.

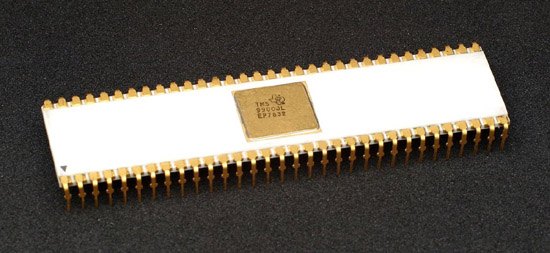

Texas Instruments TMS9900 (1976)

1976 год. Компания IBM ищет процессор для своего оригинального IBM PC. На выбор было два претендента — TMS9900 и Intel 8086/8088 (Motorola 68K находился тогда только в стадии разработки, а ждать IBM не хотела). TMS9900 имел 16 бит адресного пространства, а 8086 — 20. Казало бы, всего 25% разницы, но нет — на деле если TMS9900 мог адресовать лишь 64 КБ памяти, то 8086 — уже целый мегабайт. TI также пренебрегла разработкой 16-битного периферийного чипа, из-за чего процессор мог работать лишь по 8-битной шине с очень низкой на то время производительностью. В TMS9900 также не было встроенных регистров общего назначения — они хранились в ОЗУ. В итоге нет ничего удивительного в том, что IBM выбрала Intel, и кто знает — если бы TI смогла тогда сделать лучший процессор, то, возможно, сейчас мы бы использовали именно их продукцию.

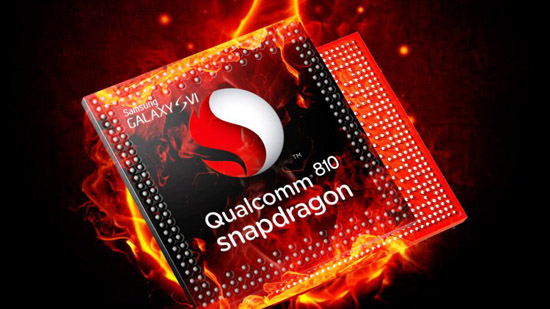

Qualcomm Snapdragon 810 (2014)

В 2014 году компания Qualcomm предпринимает первую попытку создания 8-ядерного процессора на архитектуре big.LITTLE — с 4 мощными Cortex A-57 ядрами и 4 слабыми Cortex-A53. Идея была хорошая, но вот техпроцесс был выбран крайне неудачно — это были 20 нм от TSMС. Вы помните еще какой-либо CPU на этом техпроцессе? Правильно, их больше и не было — к примеру, тот же Samsung вообще решил его пропустить, и было за что — Snapdragon 810 так и остался в нашей памяти как очень горячий процессор, который мог выдавать рекордную на тот момент производительность от силы минуту. Qualcomm пыталась исправить ситуацию, выпустив несколько ревизий этой SoC, но в итоге проблема так и не была решена.

IBM PowerPC G5 (2005)

К середине нулевых было понятно, что Intel с их архитектурой x86 все же лучше, чем IBM с PowerPC. Когда появились первые процессоры G5, Apple надеялась, что в течение года IBM все же сможет преодолеть планку в 3 ГГц и тем самым выйти на один уровень с Intel, но, увы этого так и не произошло — вернее, такая частота достигалась, но для охлаждения приходилось использовать систему водяного охлаждения. В итоге Apple было нечем заменить G4 в своих ноутбуках, в результате чего было принято решение о переходе на Intel x86.

Pentium III 1.13 ГГц (2000)

Архитектура Pentium III была прекрасной для своего времени, и топовые решения на ней в первое время даже обходили Pentium 4 с куда большей частотой. Увы — Intel с AMD тогда участвовали в гонке «кто первый выпустит процессор с частотой выше 1 ГГц», и Intel решила закрыть глаза на то, что P3 на 180 нм с частотой в целых 1.13 ГГц работают нестабильно, и выпустила их в продажу.

Итог был немного предсказуем — пользователи, купив такой горячий, дорогой, да и еще к тому же нестабильный «камушек», требовали от Intel возврата средств, так что компании пришлось отозвать всю партию. В результате стабильные решения на 1.1 и 1.13 ГГц появились лишь годом позже, в ревизии D0.

Как видите, во все времена разные компании ошибались при создании CPU. В некоторых случаях это приводило лишь к небольшим проблемам, но зачастую это стоило им значительной доли рынка, а то и вообще ухода с него. И, разумеется, выше представлены далеко не все неудачные CPU, и в следующей части мы продолжим их список.

Источник: iguides.ru

Еще никто не комментировал данный материал.

Написать комментарий