Роботы уже сочиняют песни и сами поют

Очень сложно наладить действительно хорошее взаимодействие человека и робота: один из подходов для роботов от R2-D2 до Kuri — это избежать языковой проблемы, пишет IEEE Spectrum. Вместо использования реальных слов вы можете довольно неплохо общаться, по крайней мере, на эмоциональном уровне, через разные звуковые сигналы. Но, как известно любому, кто смотрел "Звездные войны", R2-D2 много работает со звуками, которые должны быть выразительными.

Большинство современных роботов не могут позволить себе такую роскошь, как профессиональная звуковая команда (и столько постпроизводственного редактирования, сколько необходимо), поэтому возникает вопрос, как научить робота создавать правильные звуки в нужное время.

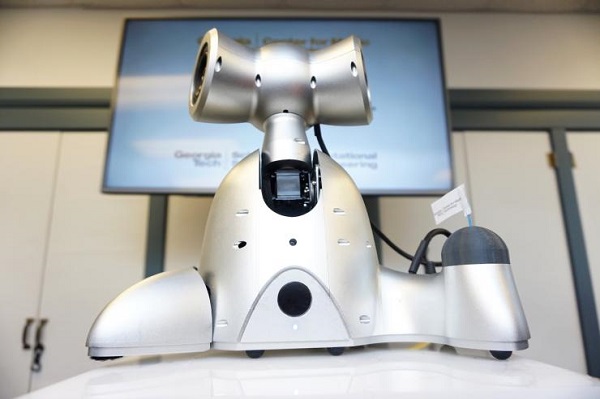

В Центре музыкальных технологий Georgia Tech (GTCMT) Гил Вайнберг и его студенты имеют большой опыт работы с роботами, которые производят различные звуки. Они использовали новую методику глубокого обучения, чтобы научить музыкального робота Шими основам понимания человеческих эмоций и правильному общению с людьми через музыку.

Шими существует с 2012 года, изначально он был запрограммирован на воспроизведение музыки, которую он будет анализировать, чтобы танцевать. Заставить Шими распознавать человеческие эмоции и реагировать на них было гораздо более сложной задачей. Чтобы научить Шими эффективно импровизировать голосом, тоном, и движениями, нужно было тренировать его с большим количеством данных:

- 10 000 файлов от 15 музыкантов, играющих "ответы" на разные эмоции.

- 300 000 примеров музыкальных инструментов.

- Один из самых редких существующих языков — почти вымерший аборигенный австралийский язык, состоящий из 28 фонем.

По словам Вайнберга, аборигенный австралийский язык отличного подходит для проекта, так как не имеет письменных традиций и в основном основан на звуке и просодии. "Робот, говорящий на обычном языке, создает этические проблемы. Например, люди хотят знать, с кем они говорят – с роботом или человеком. Поэтому мы стараемся, чтобы наши роботы отличались от людей общением. Поскольку музыка является эмоциональной и выразительной средой, в нашей Лаборатории музыкальной робототехники в GTCMT мы особенно рады изучению новых музыкальных подходов для передачи эмоций и настроений, как в голосе, так и в жестах", — пояснил Вайнберг.

Для выявления эмоций человека используется двумерная модель классификации валентности и возбуждения. Валентность определяется через семантический анализ разговорного языка, поиск слов, выражающих положительные или отрицательные чувства. Возбуждение – через анализ человеческого голоса на громкость, интенсивность, высоту тона и энергию сигнала. Пока классифицируется только четыре основных эмоции: счастье, грусть, злость и спокойствие.

"Мы только что представили исследовательское предложение, включающее создание большого набора музыкальных данных из самых разных культур по всему миру с эмоционально помеченными высказываниями, которые могут помочь нам узнать о взаимосвязи между музыкой, просодией и эмоциями среди различных культур", — поделился Гил.

Еще никто не комментировал данный материал.

Написать комментарий